设置:打开选项设置,选择好下载文件自动保存的位置(我这里选择了桌面,你也可以单独创建一个文件夹,好对批量下载的文件进行归类)

【表格处理】:Microsoft Office 2013 Excel

【文本处理】:Notepad++

【批量处理】:Windows自带命令提示符

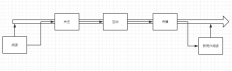

一、我们可以先看一下外链分析。

分析外链数据的主要目的是,找出垃圾外链,主动去封堵垃圾外链可能对网站造成的恶劣影响。最终目标:

1、找到垃圾外链的域名,进行防盗链处理(针对来源为垃圾域名的,直接返回404状态码);

2、处理站内可能存在问题的页面。

这里,我会重点讲解第一点;第二点比较简单,我会讲解得比较粗略。

1、定位出垃圾域名。

图注:可以看到这是一个明显不正常的趋势图

我们可以下载外链数据,来进行初步分析。

图注:下载得到的表格文件(csv逗号分隔符)

但是这样一份原始数据,是很难进行分析的。因此我们需要按照一定逻辑对其进行分析——就是按照【被链接的网页url】进行分类。

首先,我们可以快速浏览一下,进行直观判断,这些页面大部分是什么页面呢?

针对我们网站的情况来说,外链数据分为两类,正常外链与垃圾外链。

而垃圾外链又分为两种:站内搜索结果页面(垃圾搜索词)以及被黑客入侵植入的黑链(已经处理为死链)。

我们进行数据处理的目的有两个:识别出哪些是正常外链,哪些是垃圾外链,并根据垃圾外链的相关数据,进行一些处理,保护好网站;并且需要使被垃圾链接指向的页面,不被搜索引擎抓取(浪费抓取资源配额)以及被收录/索引(保证网站词库不受污染,不为网站带来形象与关键词方面的负面影响)。